G2D

masked_face_detection with Genenerative-to-Discriminative Representations

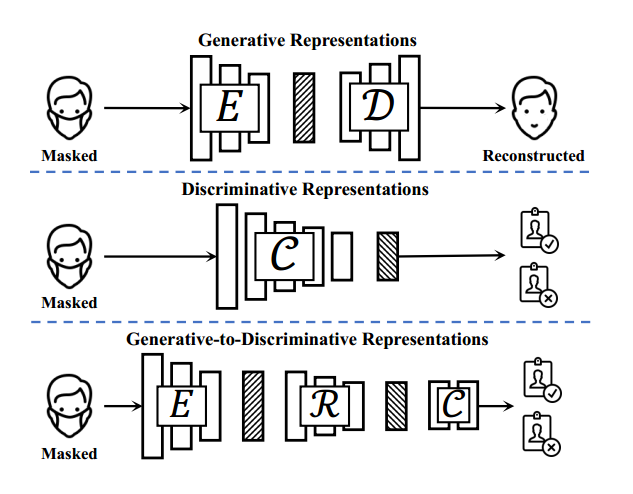

现在对于遮蔽脸部识别有两种主流的解决方案,分为生成式和识别式模型。

本篇论文的创新点在于把生成式模型和识别式模型连接了起来,形成了简称G2D的融合模型

G2D模型先由生成式模型的编码器产生注重类别信息的描述特征(category-aware descriptors),产生的特征输入到识别器模型中得到身份识别向量(identity-aware vectors)。

编码器和鉴别器作为神经网络的主干,输出的特征再给到一个分类器最终能够识别身份信息。

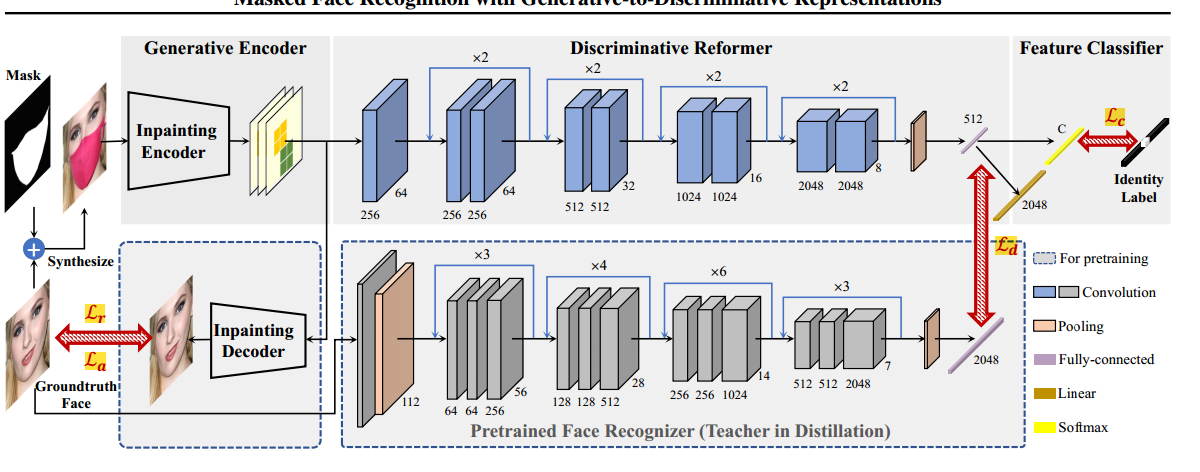

总的来说,G2D模型是由生成式编码器(generative encoder)、识别改装器(discriminative reformer )、特征分类器( Feature Classifier)顺序连接形成的模型,能够融合生成式和识别式模型的优点。

首先,生成式编码器采用预训练好的人脸绘制模型的编码器,将被遮挡的人脸表示为具有丰富被遮挡人脸一般信息的类别感知描述符,以区分人脸与其他物体;然后,判别改造器结合了一个22层卷积网络,并学习将类别感知描述符转换为身份感知向量以增强识别。最后,特征分类器级联一个全连接层和一个softmax层来识别改造后的向量。该方法将生成式编码器和判别式重构器结合在一起,作为被遮挡人脸特征提取的主干,逐步进行自监督预训练,特征分类器作为识别头。最后,对骨架进行冻结,并对标记好的被遮挡面进行特征分类器的微调。

具有三个模型,分别为生产式编码器(人脸绘制模型的一部分),提取出人脸类别感知符的表征。判别改造器用卷积神经将感知符转换回身份识别向量来加强身份识别能力,最后将识别向量导入身份识别器。

生成式编码器 (Generative Encoder)

生成式模型概念

生成式模型的思想是对遮挡部分进行重绘得到完整人脸,然后进行面部识别。

对于一般的生成式模型论文作者提出:

由于在忽视了正则化和身份保留,在图像填补时会丢失内在和外在的识别关系,一些试图加强身份信息保留的方法帮助有限的

即补全生成的图片身份识别效果不好。

相关论文:Two-Stream_Prototype_Learning_Network_for_Few-Shot_Face_Recognition_Under_Occlusions.pdf

G2D模型中的生成式编码器的选取

生成式编码器负责从被遮挡区域中提取一般的面部特征。

G2D模型中的编码器是ICT模型,一种最新的基于transfromer的图片补全模型。ICT模型包含一个transformer网络提取特征根和一个CNN网络上采样,G2D模型的编码器的输出特征来自于ICT模型上采样网络中的一个残差块。

识别器重构器 (discriminative reformer )

识别器概念

通过减少遮蔽区的影响来提取鲁棒性特征。 一些论文想通过构建更加强大的神经网络来从未遮挡区域提取出更多的信息

作者提出:

1.直接微调现有的识别模型会增加对遮蔽脸的识别能力但会减少对未遮蔽脸的识别能力。

2.对于不同种类的遮蔽类型可能会导致鲁棒性弱的特点。即对于相同人脸不同口罩的识别缺少一致性。

相关论文:Masked_Face_Transformer.pdf

G2D模型中选用的识别器

选用一个叫做Resnet-like的网络作为识别重构器,它由一个卷积层、4个残差块、一个池化层和一个全连接层组成。作者实验发现网络越深重构效果越好,但会大大增加模型复杂度。

在训练时以一个预训练的通用人脸识别器为老师,通过知识蒸馏来指导生成到判别表示的转换。

特征分类器

特征分类器从改进的判别表示中预测人脸身份。它表现为一个简单的分类头,具有一个完全连接的层和一个softmax层

分类器,只能对k类人脸进行区分。(我不清楚训练这个分类器的意义在哪里

:question:

要是在推理时用分类器,那么不是每录入一张人脸就要重新训练分类器,增加分类器输出维数吗。

事实上大多数face recognition用的是度量学习任务而不是分类任务。

通过利用特征向量余弦距离来判断match的可能性,而不是分类中softmax的最大值。

采用端到端的方式进行训练分类器参数

实验及结果分析

实验评价主要在人工合成和真实遮挡人脸两个训练集上进行

验证训练集

Celeb-A -- 作为人工合成遮蔽人脸的训练数据集

LFW -- 作为人工合成遮蔽人脸的验证数据集

RMFD&MLFW -- 真实世界遮蔽人脸的验证数据集,只使用其中真实人脸图像验证基准

验证基准

四种对比基准:

- 四个常用基础人脸识别器

- CenterLoss(CL)

- VGGFace (VGG)

- VGGFace2 (VGG2)

- ArcFace(AF)

- 选用四种人脸补全方法,将图片通过人脸补全方法预处理在输入进人脸识别器

- GFC

- DeepFill

- IDGAN

- ICT

- 微调后的遮蔽人脸识别器

- 在遮蔽人脸数据集上从头开始训练的模型

2是生成式人脸识别器,3 4

是识别式人脸识别器, 4

采用的是DoDGAN模型。所用的模型均采用达到是其发行的预训练模型。

评价:

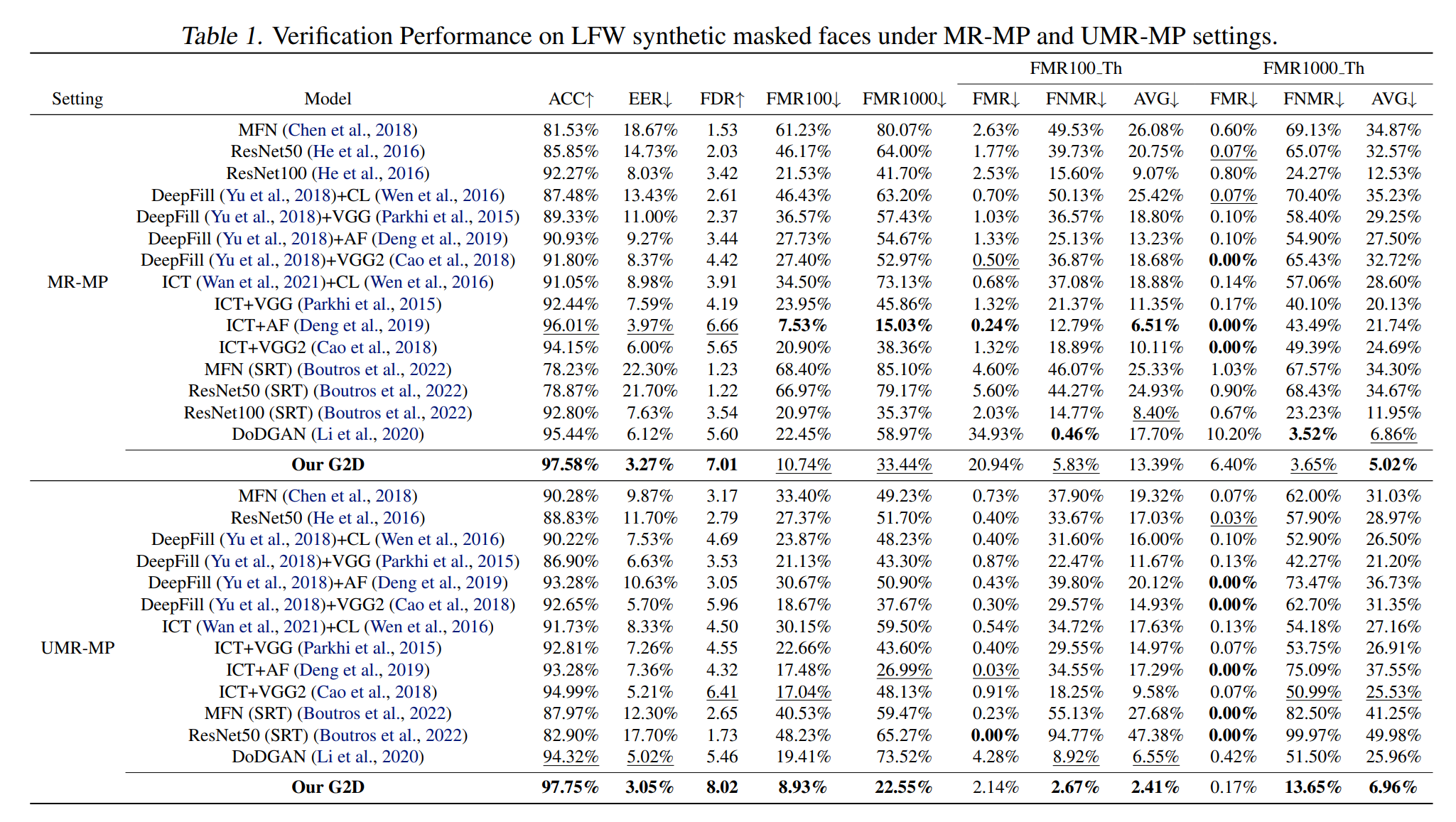

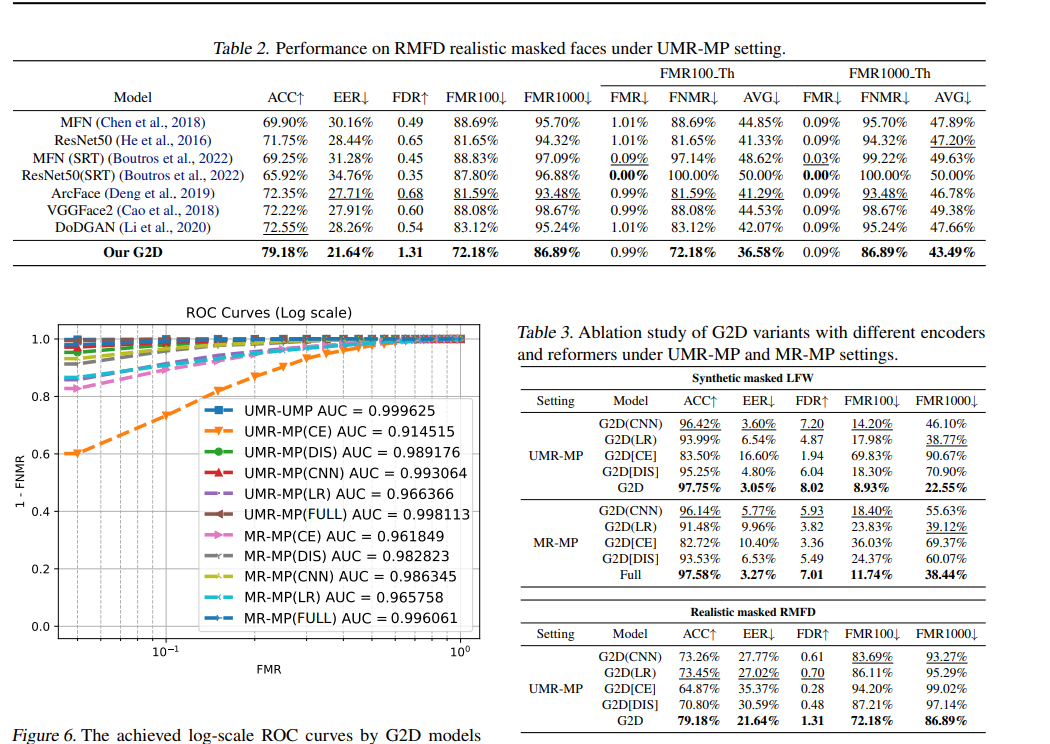

MR-MP,蒙面参考与蒙面检测

MUR-MP,非蒙面参考与蒙面检测

指标:准确率 (ACC)、等错误率 (EER)、Fisher 判别比 (FDR)、错误匹配率 (FMR)、错误不匹配率 (FNMR)、FMR ≤ 1.0% 的最低 FNMR (FMR100)、FMR ≤ 0.1% 的最低 FNMR (FMR1000),以及基于 FMR100 Th 和 FMR1000 Th 阈值计算的平均值 (AVG)

对于 FMR (false match rate (系统错误地将两种不同的输入认为是匹配的概率) )和 FNMR (false match rate (系统错误地将两个匹配的输入认为是不匹配的概率))

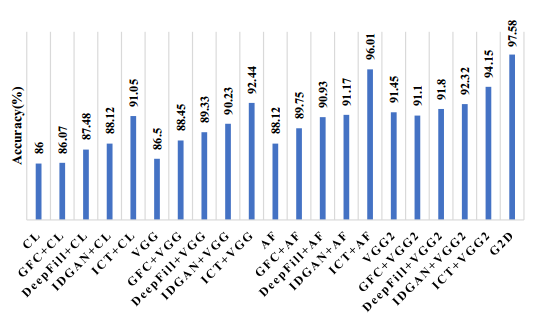

人工合成遮蔽人脸测试

采用利用LFW图片合成的遮蔽图片,由3000个正确匹配对,和3000个不正确匹配对。图片合成

基于1 2

基准的对比

G2D模型的ACC能够达到97.58%的准确率。

对于 FMR (false match rate (系统错误地将两种不同的输入认为是匹配的概率) )和 FNMR (false match rate (系统错误地将两个匹配的输入认为是不匹配的概率))

结论

- 首先,不同的掩码导致准确率明显下降,这与之前的研究结果一致(Ngan et al.,2020a;b)

- 其次,生成式人脸修复有时并不总是能够填补这一空白。我们注意到,VGG2 和 GFC 的组合比单独的 VGG2 实现的准确率更低,这表明如果修复过程不能正确地进行正则化,它可能会发挥负面作用。我们怀疑这是由于相似掩码模式的干扰和修复模型的鲁棒性较差造成的。

- 第三,在人脸修复加识别范式中,采用修复方法确实会对复合模型的性能产生影响。此外,在合成掩码 LFW 上,IDGAN 在 48×48 掩码下实现了 96.53% 的准确率(Ge et al.,2020),而我们的 G2D 即使在更复杂的掩码下也能达到 97.58%。最后,我们的 G2D 优于所有组合,证明了我们方法的有效性。

基于3 4

基准的对比

采用了两种修复方法 DeepFill 和 ICT 与四个识别器的组合,以及两个最近提出的蒙面人脸识别模型 DoDGAN (Li et al., 2020) 和 Self-Restrained Loss (SRT) (Boutros et al., 2022),以进行更定量的比较。在这里,我们不采用 IDGAN,因为它与 DeepFill 共享相同的主干,并经过完全身份监督的训练。我们打算更多地关注自监督表征学习的有效性。

对于 SRT,报告了两个基线(ResNet50和 MobileFaceNet)以及使用 SRT 损失训练的额外模块的性能。

SRT -- 损失函数旨在通过引入自我约束机制来增强模型的泛化能力和鲁棒性

如表 1 所示,对于在顶部添加额外模块对现有深度识别器进行微调的 SRT,原始基线(而不是改进后的基线)表现出更好的性能。 这表明,尽管这些解决方案可以在蒙版样本上恢复一些性能,但深度模型的泛化能力很容易受到影响。同样,最近的工作 DoDGAN(Li et al.,2020)在交叉质量评估中经历了明显的下降。本质上,这些方法不能适当地处理潜在空间中蒙版和非蒙版样本之间的分布差异。我们的 G2D 在 MR-MP 和 UMR-MP 设置上都实现了最高的准确率

FMR 和 FNMR 结果分析 值得注意的是,基于现成人脸识别器的方法显示出较低的错误匹配率 (FMR),这表明它们倾向于将更多的正对 (具有相同身份) 预测为负对,而对负对的预测受影响较小,这揭示了我们动机上的根本区别。当发生遮挡时,对于一般的人脸识别器来说,主要的挑战是预先存在的类内特征的无效化。我们的方法则不同,它教会模型怀疑和重新校准。还值得注意的是,我们的模型呈现出较低的 FMR 和 FNMR 平均值,尤其是在 UMR-MP 设置下。这表明我们提出的 G2D 在 FMR 和 FNMR 之间实现了更好的平衡,对于遮蔽和未遮蔽的有更好的泛化识别能力

真实遮挡人脸测试

在RMFD数据集上测试

可以看到在真实数据下人脸识别的正确率都有大幅下降。

具有 SRT 的模型在 FMR 和 FNMR 之间表现出极端不平衡,这表明它们对蒙面人脸识别场景过度拟合,同时几乎完全牺牲了对未蒙面人脸的判别。相反,我们的 G2D 表现出更好的连接未蒙面和蒙面人脸的能力,这在实际应用中相当有价值